Des enjeux de conformité ?

Contactez-nous pour démarrer le diagnostic de votre conformité à l'AI Act

Nous utilisons des cookies pour garantir le bon fonctionnement d’Apsodia et améliorer votre expérience. Vous pouvez accepter tous les cookies, les refuser ou personnaliser vos choix. Pour en savoir plus, consultez notre Politique de confidentialité.

Choisissez les types de cookies qu’Apsodia peut utiliser. Vous pouvez modifier vos préférences à tout moment en cliquant sur le bouton « Cookies » en bas de la page.

Indispensables au fonctionnement du site (sécurité, langue, préférences de consentement). Sans eux, Apsodia ne peut pas fonctionner correctement.

Nous aide à comprendre comment le site est utilisé (pages consultées, temps passé, etc.) afin d’améliorer Apsodia.

Utilisés pour vous proposer des contenus et offres adaptés à vos centres d’intérêt, et mesurer la performance de nos campagnes.

Permettent d’afficher des contenus intégrés (partage, likes, vidéos, etc.) issus de plateformes tierces.

Depuis août 2024, l'AI Act est entré en vigueur.

Ce règlement européen sur l'intelligence artificielle transforme la manière dont les entreprises doivent gérer leurs outils numériques.

Beaucoup de dirigeants pensent que ce sujet ne les concerne pas encore. Pourtant, votre CRM, vos chatbots, vos systèmes de tri de CV utilisent déjà de l'IA.

Et la réglementation ne fait pas de distinction entre ceux qui savent qu'ils utilisent l'IA et ceux qui l'ignorent.

Le risque n'est pas théorique : les sanctions peuvent atteindre 35 millions d'euros ou 7% du chiffre d'affaires mondial. Plus que le montant, c'est la responsabilité juridique et l'impact réputationnel qui inquiètent les entreprises averties.

Ce guide vous donne les clés pour comprendre concrètement ce qui change, identifier vos zones de risque et mettre en place une conformité pragmatique.

L'AI Act est le premier règlement mondial qui encadre spécifiquement l'intelligence artificielle.

Son objectif ? Garantir que les systèmes d'IA déployés en Europe respectent les droits fondamentaux des citoyens et des travailleurs. Contrairement aux idées reçues, ce texte ne vise pas à freiner l'innovation. Il établit un cadre pour que l'IA se développe de manière responsable et transparente.

Le règlement s'applique à toute entreprise qui développe, commercialise ou utilise des systèmes d'IA dans l'Union européenne. Peu importe votre secteur ou votre taille. Dès que vous utilisez un outil qui prend des décisions automatisées, analyse des comportements ou traite des données sensibles, vous êtes concerné. Les éditeurs de logiciels SaaS, les plateformes cloud, les solutions RH et marketing tombent presque tous dans le périmètre.

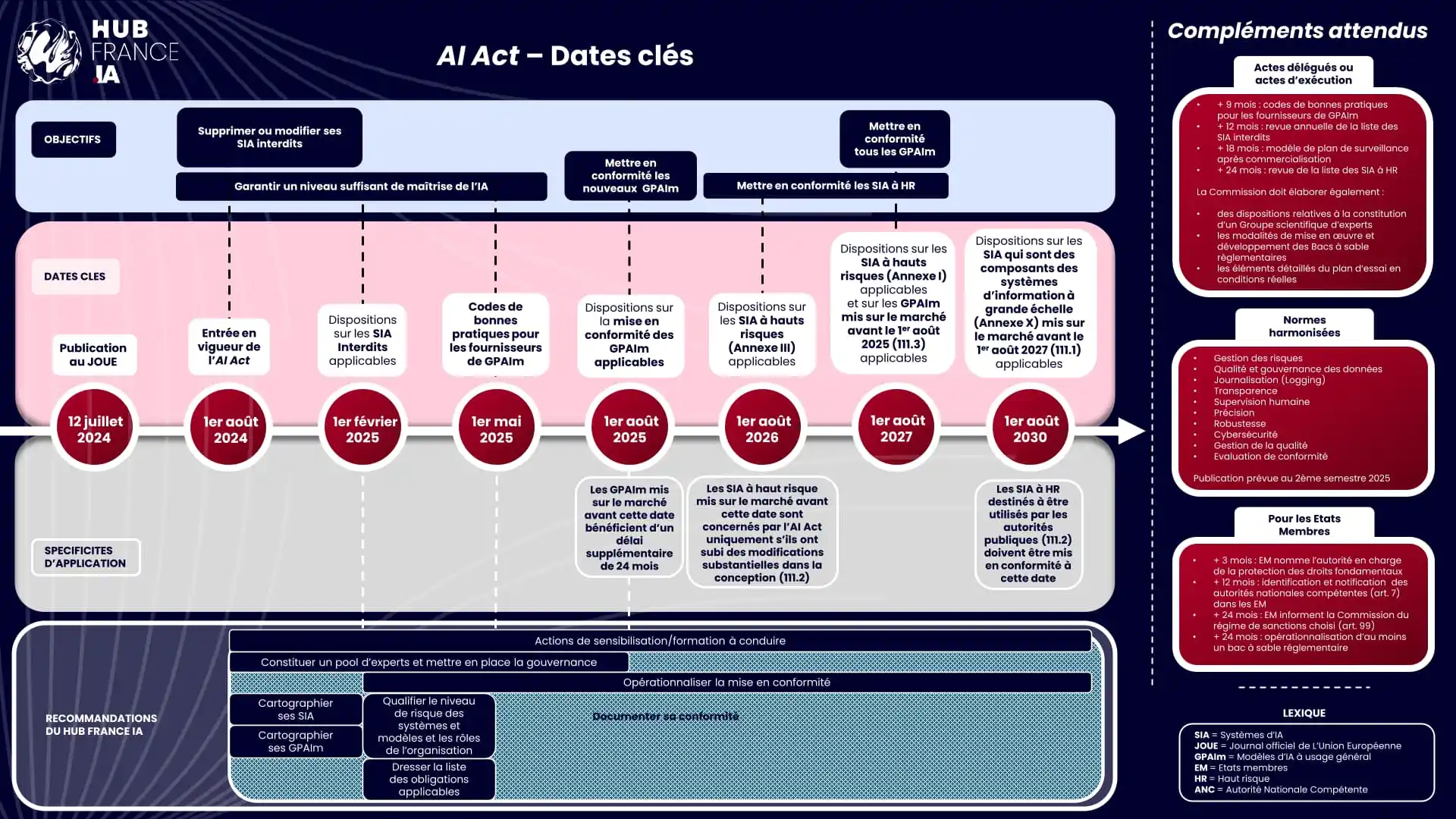

Le calendrier d'application s'étale sur plusieurs phases.

Les interdictions sur les pratiques inacceptables s'appliquent depuis février 2025. Les obligations pour les systèmes à haut risque entreront en vigueur progressivement jusqu'en 2027.

Cette mise en œuvre progressive laisse du temps, mais elle crée aussi une zone d'incertitude. Les entreprises qui anticipent prennent un avantage stratégique sur leurs concurrents.

L'Europe a choisi une approche par les risques plutôt qu'une régulation uniforme. Cette logique permet d'adapter les exigences à la réalité des usages.

Un chatbot simple n'aura pas les mêmes contraintes qu'un système de recrutement automatisé. Cette granularité rend le texte plus complexe à appréhender, mais elle évite les surcharges réglementaires inutiles.

Vous pensez peut-être ne pas utiliser d'intelligence artificielle.

Pourtant, votre entreprise en dépend probablement déjà sans que vous ne l'ayez identifié comme tel.

Les outils modernes intègrent massivement des briques d'IA : filtres anti-spam, recommandations produits, scoring de leads, analyses prédictives. Ces fonctionnalités semblent anodines, mais elles entrent dans le champ de la réglementation dès qu'elles influencent des décisions.

Prenons l'exemple d'un CRM classique. Il propose souvent des scores de maturité pour prioriser les prospects.

Ce score repose sur des algorithmes qui analysent des comportements et prédisent des intentions. Techniquement, c'est de l'IA. Si ce score influence vos actions commerciales, vous devenez utilisateur d'un système d'IA au sens de l'AI Act. Même logique pour les outils de marketing automation, les chatbots de support client ou les solutions d'analyse de données.

| Fournisseur | Déployeur | Mandataire | Importateur | Distributeur | |

|---|---|---|---|---|---|

| Risque inacceptable | Interdiction | Interdiction | Interdiction | Interdiction | Interdiction |

| Haut-risque | Obligations pour les fournisseurs d'IA à haut risque | Obligations pour les déployeurs d'IA à haut risque | Obligations pour les mandataires d'IA à haut risque | Obligations pour les importateurs d'IA à haut risque | Obligations pour les distributeurs d'IA à haut risque |

| Risque spécifique en matière de transparence | Obligations pour les fournisseurs d'IA à risque soumis à obligations de transparence | Obligations pour les déployeurs d'IA à risque soumis à obligations de transparence | Aucune obligation | Aucune obligation | Aucune obligation |

| Risque minime | Code de bonnes pratiques | Code de bonnes pratiques | Code de bonnes pratiques | Code de bonnes pratiques | Code de bonnes pratiques |

L'IA générative amplifie cette réalité. ChatGPT, Copilot, Gemini et leurs concurrents se sont généralisés en quelques mois. Vos équipes les utilisent pour rédiger des emails, créer du contenu, analyser des documents. Chaque usage constitue un point de contact avec l'AI Act.

La question n'est plus de savoir si vous utilisez l'IA, mais combien de systèmes différents traversent votre organisation.

Vous utilisez probablement plus d'IA que vous ne le pensez. Et contrairement à ce que beaucoup imaginent, le règlement ne concerne pas uniquement les développeurs d'IA. Les entreprises utilisatrices portent aussi une responsabilité. Vous devez vérifier que vos fournisseurs respectent leurs obligations, documenter vos usages et garantir une supervision humaine sur les décisions importantes. Le fait de passer par un prestataire ne vous exonère pas.

L'AI Act structure ses exigences autour de quatre niveaux de risque. Cette classification détermine les obligations qui pèsent sur vous. Comprendre dans quelle catégorie tombent vos usages est la première étape pour bâtir votre conformité.

.webp)

Manipulation cognitive, notation sociale à la chinoise, reconnaissance faciale sans autorisation judiciaire, exploitation de vulnérabilités liées à l'âge ou au handicap.

Ces usages sont bannis sans exception. Pour la plupart des entreprises françaises, cette catégorie ne pose pas de problème. Les systèmes prohibés restent rares dans le monde professionnel standard.

Il concerne les systèmes qui peuvent affecter la sécurité ou les droits fondamentaux des personnes.

Dans le monde de l'entreprise, cela touche principalement trois domaines : les ressources humaines, la relation client et les décisions financières. Un logiciel de tri de CV, une analyse automatisée de candidatures vidéo, un système de notation crédit, un outil de détection de fraude entrent dans cette catégorie.

Les exigences incluent des tests rigoureux, une documentation technique complète, des audits réguliers et une supervision humaine effective.

En RH, les outils d'aide au recrutement représentent le cas d'usage le plus sensible. Dès qu'un système filtre, classe ou recommande des candidats, il tombe sous le régime du haut risque. Peu importe que la décision finale reste humaine. L'influence de l'algorithme suffit à déclencher les obligations.

Les entreprises qui utilisent des ATS modernes doivent donc vérifier la conformité de leur éditeur et documenter leur propre usage.

Les chatbots, assistants virtuels et systèmes de génération de contenu entrent dans cette catégorie.

Vous devez informer les utilisateurs qu'ils interagissent avec une IA. Cette exigence paraît simple, mais elle demande des ajustements techniques. Votre chatbot affiche-t-il clairement sa nature artificielle ? Vos contenus générés portent-ils une mention explicite ? Ces détails peuvent sembler cosmétiques, mais ils constituent des obligations légales.

Les filtres anti-spam, les correcteurs orthographiques, les systèmes de recommandation produits basiques ne déclenchent aucune obligation spécifique. Vous restez libre de les utiliser sans contrainte particulière. Mais attention : même ces systèmes doivent respecter le RGPD et les règles générales de protection des données.

Au-delà des catégories théoriques, l'AI Act impose des changements organisationnels concrets. Ces transformations touchent vos processus internes, votre gouvernance et vos pratiques managériales. Anticiper ces impacts vous permet de les absorber progressivement plutôt que de les subir dans l'urgence.

La documentation devient une obligation centrale. Pour chaque système d'IA à risque élevé, vous devez maintenir un dossier technique.

Ce dossier décrit le fonctionnement de l'algorithme, les données utilisées, les tests réalisés, les risques identifiés et les mesures de supervision.

Si vous développez l'IA en interne, cette charge vous incombe directement. Si vous utilisez un outil tiers, vous devez obtenir ces informations de votre fournisseur et vérifier leur cohérence avec votre usage réel.

La gouvernance IA devient une fonction à part entière. Quelqu'un dans votre organisation doit cartographier les usages, évaluer les risques, suivre la conformité et coordonner les actions. Cette responsabilité ne peut pas rester floue. Les entreprises matures créent un comité IA qui réunit juridique, technique, métier et direction. Ce comité valide les nouveaux usages, contrôle la conformité des outils existants et pilote les plans de mise en conformité.

Les responsabilités managériales se redéfinissent. Les managers qui déploient des outils d'IA dans leurs équipes ne peuvent plus se contenter de valider un achat. Ils doivent comprendre les risques, former leurs collaborateurs, superviser les décisions et documenter les incidents. Cette montée en compétence demande du temps et des ressources. Elle transforme aussi la relation entre la direction et les équipes opérationnelles.

Le risque financier et réputationnel reste la motivation principale pour agir. Les sanctions prévues par l'AI Act atteignent des niveaux dissuasifs : jusqu'à 35 millions d'euros pour les infractions les plus graves. Mais au-delà de l'amende, c'est l'impact médiatique qui inquiète. Une entreprise épinglée pour mauvais usage d'IA perd la confiance de ses clients, de ses candidats et de ses partenaires. Dans un marché où la réputation se construit en années et se détruit en heures, ce risque pèse lourd.

Le coût de l'inaction dépasse largement le coût de la mise en conformité. Reporter les ajustements ne fait qu'amplifier la dette technique et organisationnelle. Les entreprises qui agissent maintenant transforment une contrainte en avantage concurrentiel. Elles rassurent leurs clients, attirent les talents sensibles à l'éthique et structurent leur croissance sur des bases solides.

Pour évaluer rapidement votre exposition à l'AI Act, posez-vous ces questions concrètes. Elles couvrent les principaux cas d'usage professionnels et vous permettent d'identifier vos zones de vigilance.

Utilisez-vous des outils qui prennent ou influencent des décisions ? Un CRM qui score vos prospects, un logiciel RH qui filtre les CV, une plateforme marketing qui optimise vos campagnes, un système de tarification dynamique. Chacun de ces outils repose probablement sur de l'IA. Si la réponse est oui, vous devez creuser.

Vos processus incluent-ils des décisions automatisées ? Validation automatique de crédit, refus de candidature sans intervention humaine, blocage de compte client, tarification personnalisée. Dès qu'une décision importante se prend sans validation humaine effective, le risque réglementaire augmente. L'AI Act exige une supervision humaine réelle, pas juste formelle.

Travaillez-vous avec des données sensibles ou personnelles ? Les données de santé, les informations biométriques, les données RH, les données financières tombent sous une protection renforcée. Si vos systèmes d'IA traitent ces informations, vos obligations se renforcent. Le croisement RGPD + AI Act crée des exigences cumulatives.

Vos équipes utilisent-elles des outils d'IA générative ? ChatGPT, Copilot, Gemini, Claude se sont généralisés en quelques mois. Leur usage professionnel soulève plusieurs questions : où vont les données partagées ? Comment garantir la confidentialité ? Les contenus générés sont-ils vérifiés ? Une utilisation non encadrée expose à des fuites de données et des erreurs factuelles.

Si vous répondez oui à au moins deux de ces questions, votre entreprise doit engager une démarche de conformité AI Act. Plus vous accumulez de réponses positives, plus votre exposition est significative. Le diagnostic complet demande un audit approfondi, mais ces questions donnent déjà une première indication.

Répondez à ces 5 questions pour le savoir

La conformité AI Act ne se construit pas en un jour. Elle demande une approche méthodique, progressive et pragmatique. L'objectif n'est pas d'atteindre la perfection immédiate, mais de réduire les risques prioritaires tout en maintenant votre activité.

Cartographier les usages IA constitue la première étape. Vous ne pouvez pas gérer ce que vous ne connaissez pas. Listez tous les outils et processus qui utilisent de l'IA, même indirectement. Cette cartographie doit couvrir les achats officiels, mais aussi les outils utilisés par les équipes sans validation formelle. Les Shadow IT et les usages non déclarés représentent souvent les plus gros risques.

Pour chaque outil identifié, collectez les informations essentielles : éditeur, finalité, données traitées, niveau d'automatisation, population concernée. Cette base de données devient votre référentiel IA. Elle vous permet de prioriser, de suivre les évolutions et de répondre rapidement en cas de contrôle.

Évaluer les risques transforme votre inventaire en plan d'action. Pour chaque système, déterminez son niveau de risque selon les critères de l'AI Act. Cette évaluation croise la classification réglementaire avec vos spécificités métier. Un même outil peut présenter des risques différents selon l'usage que vous en faites. Un chatbot commercial reste à risque limité, mais un chatbot RH qui présélectionne des candidats bascule en risque élevé.

L'évaluation doit aussi considérer vos capacités de maîtrise. Disposez-vous de la documentation technique ? Pouvez-vous auditer l'algorithme ? Avez-vous une supervision humaine effective ? Ces questions révèlent vos vulnérabilités opérationnelles au-delà du risque théorique.

Prioriser vos actions évite la paralysie. Vous ne pouvez pas tout traiter simultanément. Concentrez-vous d'abord sur les risques élevés, puis les risques limités, enfin les ajustements organisationnels généraux. Cette priorisation tient compte des échéances réglementaires, de vos ressources disponibles et de vos contraintes business.

Les systèmes à haut risque demandent une action rapide. Si vous ne disposez pas de la documentation nécessaire, sollicitez-la auprès de vos éditeurs. Si vous n'obtenez pas de réponse satisfaisante, envisagez des alternatives ou des mesures compensatoires. La temporisation n'est pas une option pour cette catégorie.

Mettre en conformité progressivement signifie itérer plutôt que viser la perfection. Commencez par les ajustements les plus simples : mentions de transparence, documentation basique, processus de supervision. Puis renforcez progressivement : audits techniques, tests de robustesse, plans de contingence. Cette approche agile vous permet d'avancer sans bloquer votre activité.

Chaque itération produit de la valeur. Elle réduit vos risques, renforce votre maîtrise et améliore votre crédibilité. Elle génère aussi des apprentissages qui nourrissent les cycles suivants. La conformité AI Act n'est pas un projet ponctuel mais un processus continu d'amélioration.

Former les équipes complète le dispositif. Vos collaborateurs doivent comprendre les enjeux, connaître les règles et adopter les bons réflexes. Cette formation cible plusieurs populations : les managers qui déploient l'IA, les utilisateurs finaux, les équipes techniques, les fonctions support. Chacune a besoin d'un niveau d'information adapté à son rôle.

La formation ne se limite pas à un webinaire unique. Elle s'inscrit dans la durée, s'adapte aux évolutions réglementaires et intègre les retours d'expérience. Les entreprises matures créent des ressources internes : guides pratiques, FAQ, points de contact identifiés. Cette infrastructure facilite l'appropriation et réduit la charge de la fonction conformité.

Face aux obligations de l'AI Act, vous pouvez choisir de gérer la conformité en interne ou de vous faire accompagner. Cette décision dépend de vos ressources, de vos compétences et de votre appétence au risque. Aucune approche n'est universellement meilleure. Chacune présente des avantages et des limites.

Gérer en interne fonctionne si vous disposez des compétences nécessaires. Cela demande de maîtriser trois dimensions : la compréhension réglementaire, l'expertise technique sur l'IA et la connaissance de vos processus métier. Cette triple compétence reste rare. Peu d'entreprises ont un profil capable de croiser ces trois dimensions de manière opérationnelle.

L'approche interne présente des avantages. Elle favorise l'appropriation, réduit les coûts directs et renforce votre autonomie à long terme. Elle permet aussi d'ajuster en continu sans dépendre d'un prestataire externe. Pour des entreprises de taille significative avec des équipes juridiques et techniques étoffées, cette option reste viable.

Mais elle comporte des risques. Sans expertise spécialisée, vous risquez des angles morts. Un juriste classique maîtrise mal les spécificités techniques de l'IA. Un développeur connaît peu les subtilités réglementaires. Les équipes métier peinent à identifier tous les usages d'IA disséminés dans l'organisation. Cette fragmentation crée des vulnérabilités.

L'accompagnement externe apporte une expertise concentrée. Un partenaire spécialisé dispose d'une connaissance approfondie de la réglementation, d'une expérience multi-clients et d'une méthodologie éprouvée. Il identifie rapidement vos zones de risque, vous guide sur les priorités et accélère votre mise en conformité.

L'IA reste un sujet hybride qui demande des compétences transverses. Vous ne pouvez pas le traiter uniquement sous l'angle juridique, ni exclusivement sous l'angle technique. L'approche doit croiser conformité réglementaire, architecture technique et réalité métier. Cette transversalité justifie un accompagnement qui apporte ces trois regards simultanément.

Le bon choix dépend de votre maturité actuelle. Si vous débutez sur le sujet, un accompagnement externe structure votre démarche et vous évite les erreurs coûteuses. Si vous avez déjà avancé, un audit ponctuel ou un conseil ciblé peut suffire. L'essentiel est de ne pas sous-estimer la complexité du sujet ni surestimer vos capacités internes.

Chez Apsodia, nous accompagnons les entreprises françaises dans leur mise en conformité AI Act avec une approche opérationnelle et pragmatique. Notre positionnement diffère des cabinets juridiques classiques. Nous ne faisons pas de conseil juridique pur. Nous traduisons les obligations réglementaires en actions concrètes adaptées à votre contexte business.

Notre expertise croise trois dimensions : la compréhension technique de l'IA, la maîtrise des enjeux réglementaires et la connaissance des réalités opérationnelles des PME et ETI. Cette triple compétence nous permet d'identifier rapidement vos usages d'IA, d'évaluer vos risques réels et de construire un plan de conformité réaliste. Nous parlons le langage des dirigeants et des équipes métier, pas uniquement celui des juristes ou des développeurs.

Nous concentrons notre action sur les entreprises de taille intermédiaire. Les grands groupes disposent de ressources internes et de cabinets spécialisés. Les très petites structures ont des expositions limitées. Notre cœur de cible regroupe les entreprises qui utilisent massivement l'IA sans avoir forcément les moyens d'une direction conformité dédiée. Nous les aidons à structurer leur démarche sans mobiliser des ressources disproportionnées.

Notre vision dépasse la simple conformité réglementaire. Nous croyons que l'IA doit être utile, responsable et performante. Utile signifie qu'elle apporte une vraie valeur métier, pas juste un effet de mode. Responsable implique qu'elle respecte les personnes, les données et les règles. Performante garantit qu'elle améliore réellement vos résultats business. Cette triple exigence guide tous nos accompagnements.

Nous construisons avec vous une conformité durable qui s'adapte aux évolutions réglementaires et à vos transformations métier. L'AI Act n'est qu'une première étape. D'autres réglementations suivront. Les usages de l'IA continueront d'évoluer. Notre accompagnement vous prépare à ces changements plutôt que de vous enfermer dans une conformité figée.

Si vous souhaitez évaluer votre situation, nous proposons un audit AI Act qui cartographie vos usages, évalue vos risques et identifie vos priorités. Cet audit dure généralement une à deux semaines et produit un rapport opérationnel avec un plan d'action chiffré. Contactez-nous pour échanger sur votre contexte et définir l'accompagnement le plus adapté.

L'AI Act s'applique-t-il aux PME ?

Oui, sans exception. Le règlement concerne toute entreprise qui utilise de l'IA dans l'Union européenne, quelle que soit sa taille. Les PME bénéficient de quelques allègements procéduraux, mais les obligations de fond restent identiques. Une entreprise de 20 personnes qui utilise un logiciel de recrutement automatisé a les mêmes responsabilités qu'un grand groupe.

Est-ce obligatoire ?

L'AI Act est un règlement européen directement applicable dans tous les États membres. Il ne nécessite aucune transposition en droit national. Depuis août 2024, il constitue un cadre légal contraignant. L'ignorer vous expose à des sanctions administratives et à des risques juridiques en cas de litige.

Quelles sanctions en cas de non-conformité ?

Les sanctions varient selon la gravité de l'infraction. L'utilisation de systèmes interdits peut coûter jusqu'à 35 millions d'euros ou 7% du chiffre d'affaires mondial. Le non-respect des obligations sur les systèmes à haut risque atteint 15 millions d'euros ou 3% du CA. Les manquements de transparence sont sanctionnés jusqu'à 7,5 millions ou 1,5% du CA. Ces montants maximums s'appliquent rarement, mais ils montrent le niveau de risque.

L'IA générative comme ChatGPT est-elle concernée ?

Oui, sur deux plans. Les éditeurs d'IA générative doivent respecter des obligations spécifiques de transparence et de gestion des risques. Les entreprises utilisatrices doivent informer leurs interlocuteurs quand elles utilisent l'IA pour produire du contenu. Elles doivent aussi s'assurer que les données partagées avec ces outils ne violent pas la confidentialité ou le RGPD.

Dois-je arrêter certains outils pour être conforme ?

Pas nécessairement. L'objectif de l'AI Act n'est pas d'interdire l'IA mais de l'encadrer. Dans la plupart des cas, vous pouvez continuer à utiliser vos outils actuels en ajoutant des mesures de supervision, de documentation et de transparence. Seuls les systèmes qui tombent dans la catégorie "risque inacceptable" doivent être abandonnés, et ils restent rares dans le monde professionnel standard.

Contactez-nous pour démarrer le diagnostic de votre conformité à l'AI Act